Wir freuen uns über Ihr Interesse am Thema Erklärbare KI. Auf dieser Seite erwarten Sie Antworten auf die Fragen, was sich hinter dem Begriff Erklärbare KI verbirgt und welche Ziele mit Hilfe von Erklärbarer KI erreicht werden sollen. Zudem erfahren Sie, wie das Ganze konkret aussehen kann. Hierfür stellen wir Ihnen verschiedene Methoden der Erklärbarkeit vor und geben Ihnen einen Überblick zum aktuellen Stand von Erklärbarer KI.

Künstliche Intelligenz (KI) nimmt einen immer größeren Platz in unserem Leben ein. Von Chatbots, Spam-Filtern und Shopping-Empfehlungen für Privatpersonen bis hin zu Betrugserkennung bei Finanzdienstleistern und Marketingmaßnahmen für Unternehmen – hinter vielem steckt inzwischen KI. Die zunehmende Verbreitung von KI-Systemen eröffnet ungeahnte Möglichkeiten.

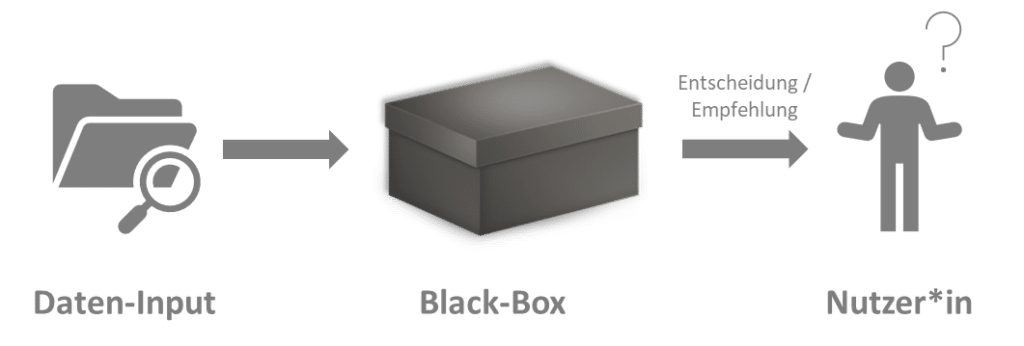

KI-Systeme sind von Menschen entwickelte Software- oder Hardwaresysteme, welche ihre Umgebung durch Datenerfassung wahrnehmen und die gesammelten Daten verarbeiten. Durch die so gewonnenen Informationen treffen die KI-Systeme eine Entscheidung über die besten Maßnahmen, um ein vorgegebenes Ziel zu erreichen. Die Verhaltensweisen einer KI sind aufgrund ihrer Komplexität für den Menschen jedoch nicht ohne Weiteres nachvollziehbar. Deswegen spricht man hier von einer sogenannten „Black Box“.

KI-Anwendungen in der Verkehrssteuerung oder bei medizinischen Diagnosen, die schlussendlich über Leben und Tod entscheiden könnten, stehen unter besonderes kritischer Beobachtung. So zeigen aktuelle Studien, dass viele Europäer*innen automatisierten Entscheidungen von KI-Systemen mit Unbehagen gegenüberstehen. Und das selbst dann, wenn die Algorithmen nachweislich bessere Ergebnisse liefern als menschliche Expert*innen.

Was viele KI-Systeme bisher nämlich nicht leisten, ist, ihre Funktionsweise verständlich und transparent zu machen. Das liegt in der Natur der Sache: Die meisten KI-Systeme kommen dort zum Einsatz, wo die Lösungswege alles andere als offensichtlich sind. Sonst hätte man ja auch gleich eine herkömmliche Software programmieren können. Dank komplexer Algorithmen mit oft vielen Millionen Parametern können KI-Verfahren die Lösung erschließen. Für den Menschen, der von der KI profitieren soll, ist genau dieser Umstand ein Problem. Wie kann man einer Maschine vertrauen, die einen über die Vorgänge in ihrem Innern im Dunkeln lässt? In der Fachsprache sagt man, dass das KI-System wie eine „Black Box“ agiert. Besonders in schwerwiegenden Entscheidungsszenarien ruft solch ein Verhalten zurecht Skepsis hervor: Die Diagnose eines Krankheitsbildes, die Überprüfung von Identitäten oder das Fahrmanöver eines selbstfahrenden Autos müssen unbedingt gut begründet und nachvollziehbar sein.

Deshalb fordern Gesellschaft und Politik Transparenz und Nachvollziehbarkeit der KI-Entscheidungen. Denn wenn gute Begründungen und Nachvollziehbarkeit schon bei menschlichen Entscheidungen wichtig sind, wie viel mehr dann bei solchen, die von einer Maschine berechnet werden? Und genau hier kommt die Erklärbare KI (engl. Explainable Artificial Intelligence, XAI) ins Spiel.

Welchem KI-System würden Sie mehr vertrauen?

Stellen Sie sich vor, in 5 Jahren fällt Ihnen ein seltsames Muttermal auf Ihrem Unterarm auf. Mittlerweile werden Ärzt*innen von KI unterstützt, daher fragen Sie eine KI um Rat.

a) Die KI liefert ein sehr sicheres Ergebnis ohne Erklärung:

Der Befund ist zu 97,5 % negativ.

b) Die KI liefert ein recht sicheres Ergebnis mit Erklärung:

Der Befund ist zu 90 % negativ, weil die Form des Muttermals nicht unregelmäßig ist, die Konturen scharf und nicht ausgefranst sind und das Muttermal einheitlich gefärbt ist.

Erklärbare KI (engl. Explainable Artificial Intelligence, XAI) ist ein Begriff, der nicht einheitlich definiert ist. Damit gemeint sind meist Technologien und Maßnahmen, welche dafür sorgen, dass die Transparenz eines KI-Systems steigt. Ziel ist immer, die Ergebnisse oder die interne Funktionsweise von KI-Systemen für menschliche Anwender*innen verständlich zu machen. Üblicherweise werden Methoden der Erklärbaren KI in Ergänzung zu einem bestehenden KI-System eingesetzt. Sie produzieren automatisiert verständliche Ergebnisse und Ausgaben, die ein gewöhnliches KI-System oftmals selbst nicht liefern kann.

Erklärbare KI befasst sich damit, die Entscheidungen, Empfehlungen und Prognosen von KI-Systemen für ihre Nutzer*innen verständlich und nachvollziehbar zu machen.

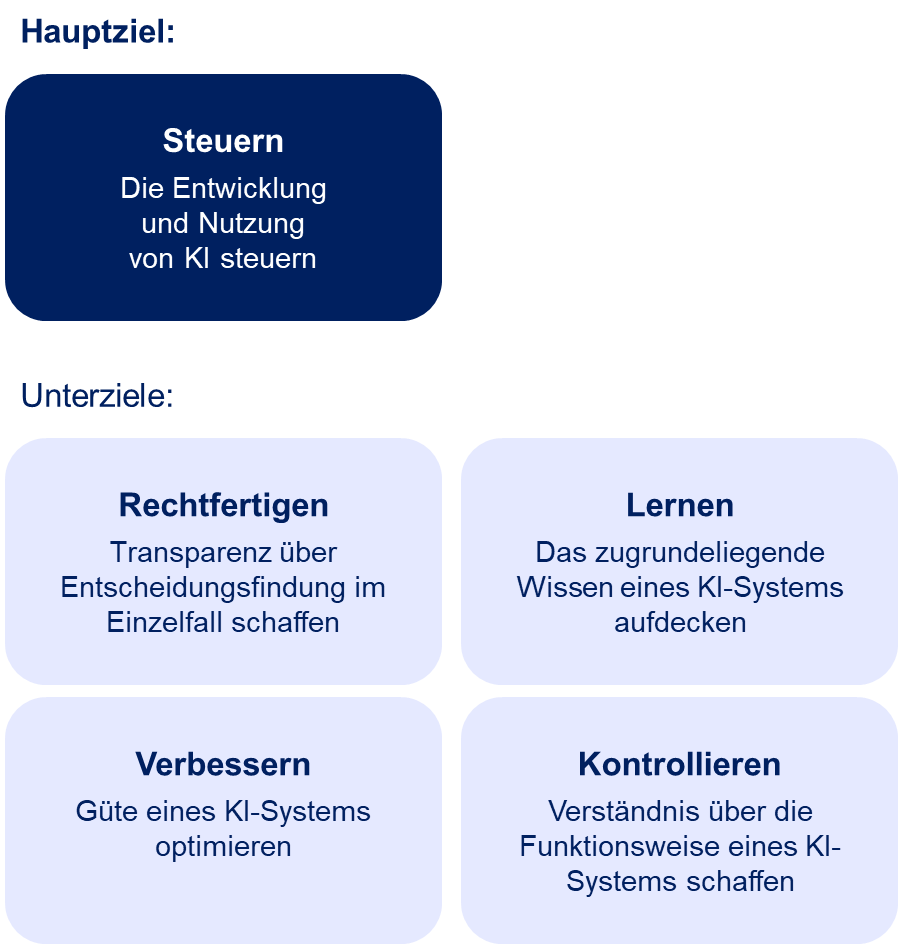

Die Motivation für die Entwicklung und Umsetzung von Erklärbarer KI unterscheidet sich je nach Anwendungsfall und den Bedürfnissen der jeweiligen Zielgruppen. Dennoch können übergeordnete Ziele von Erklärbarer KI formuliert werden.

Wird die Zielsetzung auf ein konkretes Publikum angepasst, spricht man von nutzerzentrierter Erklärbarer KI (engl. user-centric XAI). Wenn der Fokus auf technische Expert*innen wie zum Beispiel Softwareentwickler*innen oder Data Scientists gelegt wird, soll die Funktionsweise eines KI-Systems nachvollziehbar sein. Hierbei wird jedoch hohe Fachkompetenz der Nutzenden vorausgesetzt. Wenn der Fokus auf Fachexpert*innen – zum Beispiel Ärzt*innen, welche durch KI-Systeme unterstützt werden – gelegt wird, muss die Verlässlichkeit und Entscheidungsfindung eines KI-Systems beurteilt werden können. Die Erklärungen müssen dann auf den Kenntnisstand und die Bedürfnisse des jeweiligen Nutzenden abgestimmt sein. Nur so kann ein angemessenes Vertrauen in KI-Systeme geschaffen werden.

Methoden der Erklärbaren KI werden mit dem Ziel entwickelt, die auf automatisierte Weise erzeugten Ausgaben eines KI-Systems für ihre Nutzer*innen verständlich zu machen. Aufbauend auf verschiedenen Fragestellungen erhalten Sie im folgenden Abschnitt einen Überblick von verschiedenen Methoden der Erklärbarkeit.

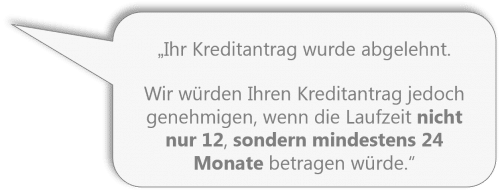

Kontrafaktische Erklärmethoden gehören oft zur Klasse der post-hoc-Erklärungen, die erst nachträglich erzeugt werden. Statt zu zeigen, wie das Modell funktioniert, werden Belege für die „Denkweise“ geliefert, auf denen die Entscheidung beruht. Solche Belege können beispielsweise textuelle Beschreibungen sein. Im Gegensatz dazu stehen intrinsische Erklärungen, die bereits während der Entscheidungsfindung des KI-Systems entstehen.

Dass auf dem Bildausschnitt eine Kamera zu sehen ist, macht das eingesetzte KI-System an den im rechten Bild extrahierten Bildbereichen fest.

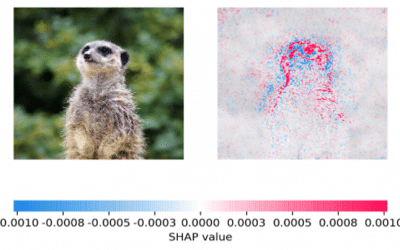

Es werden einzelne Input-Output-Paare analysiert und nach ihrer Wichtigkeit sortiert. Diese Familie von Methoden nennt sich Feature Importance und kommt häufig bei der Entwicklung und Prüfung von KI-Systemen zum Einsatz. Viele Feature-Importance-Methoden sind modell-agnostisch, können also für beliebige KI-Systeme eingesetzt werden.

Hier wird deutlich, welche Features des Erdmännchens den größten Einfluss auf die Entscheidung der KI haben: Hauptsächlich die Umrandung des Kopfes.

Die wachsende Bedeutung von KI-Systemen macht es für Unternehmen unausweichlich, bei ihren Kund*innen und Mitarbeiter*innen die Akzeptanz von algorithmisch basierten Entscheidungen zu erhöhen. Deshalb wird die Nachvollziehbarkeit von KI-Entscheidungen aus Sicht der Nutzer*innen immer wichtiger.

Was Erklärbare KI bereits heute leistet:

Wie kann Erklärbare KI dazu beitragen, das Potential Künstlicher Intelligenz zur Entfaltung zu bringen? Genau diese Frage wollen wir gemeinsam mit Ihnen im XAI-Studio beantworten.

© 2022 Erklärbare KI | Institut für Business Analytics der Universität Ulm