Der „Skill-Kompass“ ist ein digitaler Bildungsberater, der Jugendlichen individuell Bildungsangebote vorschlägt. Das KI-basierte Empfehlungssystem lernt die persönlichen Interessen und Ziele seiner Nutzer*innen mit jeder Interaktion besser kennen und kann passgenau beraten.

Dank Methoden der Erklärbaren KI kann der Skill-Kompass seine Empfehlungen begründen. Ganz ähnlich wie in einem Gespräch mit menschlichen Mentor*innen können die Jugendlichen die Vorschläge nachvollziehen, sich selbst reflektieren und dem Skill-Kompass auch widersprechen. Aus diesem Feedback wiederum lernt der Skill-Kompass und kann in Zukunft passendere Vorschläge geben.

Das Konzept für den Skill-Kompass wurde als Kooperation zwischen der Universität Ulm, der Start-Stiftung und Kiron Open Higher Education entworfen und 2021 in einem Wettbewerb des Bundesministeriums für Arbeit und Soziales ausgezeichnet. Über das Schuljahr 2022/23 hinweg findet die technische Umsetzung des Skill-Kompasses statt, die das XAI-Studio (Inlinity und das Institut für Business Analytics) gemeinsam mit der Start-Stiftung realisiert.

Zwar wird der Skill-Kompass mit dem Ziel entwickelt, die bestehenden Bildungs- und Beratungsangebote der Start-Stiftung für eine größere Gruppe zugänglich zu machen. Die Technologie ist in ihrer Anwendung jedoch universell und kann auf viele weitere Bereiche, beispielsweise die betriebliche Weiterbildung, übertragen werden.

Kann diese Technologie auch Ihnen weiterhelfen?

Dieser Ansatz stammt direkt aus unserer Forschung und ist bereit für einen ersten Test in der Praxis.

Phishing-Attacken sind ein großes Risiko für Unternehmen und Privatpersonen. Jedes Jahr entstehen Millionenschäden, weil Anwender*innen auf nahezu perfekt gefälschte E-Mails hereinfallen.

Machine-Learning-basierte Phishing-Detektoren sortieren viele dieser Phishing-Mails automatisch aus. Aber je empfindlicher der Detektor eingestellt wird, umso größer ist die Gefahr, dass fälschlicherweise auch echte E-Mails aussortiert werden. Damit das nicht passiert, muss die Empfindlichkeit entsprechend niedrig eingestellt werden, mit der Folge, dass immer wieder auch gut gemachte Phishing-Mails in E-Mail-Postfächern landen.

Wie kann Erklärbare KI hier helfen? Sie kommt dann zum Einsatz, wenn der Phishing-Detektor unsicher ist und daher entscheidet, lieber eine mögliche Phishing-E-Mail durchzulassen, als das Risiko einzugehen, fälschlicherweise eine echte E-Mail zu verwerfen. In diesen Fällen kann mit Erklärbarer KI ermittelt werden, welche Merkmale und Textpassagen in der E-Mail dazu führten, dass der Detektor angeschlagen hat. Öffnen Nutzer*innen eine solche als Verdachtsfall eingestufte E-Mail, werden die entsprechenden Stellen deutlich markiert. Das weckt die Aufmerksamkeit, lenkt den Blick auf mögliche Erkennungsmerkmale von Phishing-Angriffen und ermöglicht eine situationsbezogene Analyse – anders als beispielsweise generische Warnmeldungen, die allzu oft unbeachtet weggeklickt werden.

Dieser Ansatz stammt direkt aus unserer Forschung und ist bereit für einen ersten Test in der Praxis.

Wer seine Immobilie verkaufen will, möchte wissen, wie viel diese wert ist. Im Zeitalter des Internets kann man Immobilien unkompliziert auf speziellen Websites von KI-Systemen bewerten lassen. Die Frage ist nur: Wie kommt der angezeigte Preis zustande? Und warum wurde die Immobilie nicht besser (oder schlechter) bewertet?

Der Vergleich mit einer alternativen Immobilie ist eine gute Möglichkeit, eine solche Bewertung zu verstehen. Diesen Ansatz verfolgen eine ganze Reihe von Methoden der Erklärbaren KI: Sie erzeugen eine fiktive Immobilie, die einen höheren oder niedrigeren Preis erhalten würde. Die Nutzer*innen können dann ihre eigene Immobilie mit diesem Gegenbeispiel vergleichen und auf diese Weise ein Verständnis für das Zustandekommen des Preises entwickeln.

Von zentraler Bedeutung bei dieser Art von „Erklärungen“ ist, dass die fiktive Immobilie nicht nur vom KI-System wie gewünscht besser oder schlechter eingestuft wird, sondern auch in den Augen der menschlichen Nutzer*innen ein gutes Gegenbeispiel darstellt. Dazu gehört, dass die fiktive Immobilie realistisch und typisch ist, also tatsächlich so existieren könnte. Gleichzeitig sollte der Unterschied nicht allzu groß sein. Denn natürlich erzielt eine Vorstadtvilla in der Regel einen deutlich höheren Preis als eine kleine Wohnung in einem kleinen Dorf im Nirgendwo – das hätten sich die Nutzer*innen aber auch selbst denken können. Fachleute bezeichnen die Eigenschaft, dass ein Gegenbeispiel mit den Erwartungen der Nutzer*innen übereinstimmt, als „Kohärenz“. Diese zu erreichen, ist für viele Methoden der Erklärbaren KI noch eine große Herausforderung.

Eine am Institut für Business Analytics der Universität Ulm entwickelte Methode stellt mit Hilfe von Wahrscheinlichkeitsdichten und gradientenfreier Optimierung sicher, dass ein Gegenbeispiel typisch, realistisch und ähnlich der ursprünglichen Immobilie ist. Für diesen innovativen Ansatz, der in Studien mit Nutzer*innen validiert wurde, wurde das Ulmer Forscherteam für den Best Paper Award der 54. Hawaii International Conference on System Sciences nominiert.

Betreiben Sie KI-Systeme, bei denen Nutzer*innen mit Bewertungen konfrontiert werden?

Gerne helfen wir Ihnen dabei, mit Erklärbarer KI sicherzustellen, dass diese Bewertungen nachvollziehbar werden und das Vertrauen Ihrer Nutzer*innen in das KI-System – und damit ihre Zufriedenheit – steigt.

Betreiben Sie KI-Systeme, bei denen Nutzer*innen mit Bewertungen konfrontiert werden?

Gerne helfen wir Ihnen dabei, mit Erklärbarer KI sicherzustellen, dass diese Bewertungen nachvollziehbar werden und das Vertrauen Ihrer Nutzer*innen in das KI-System – und damit ihre Zufriedenheit – steigt.

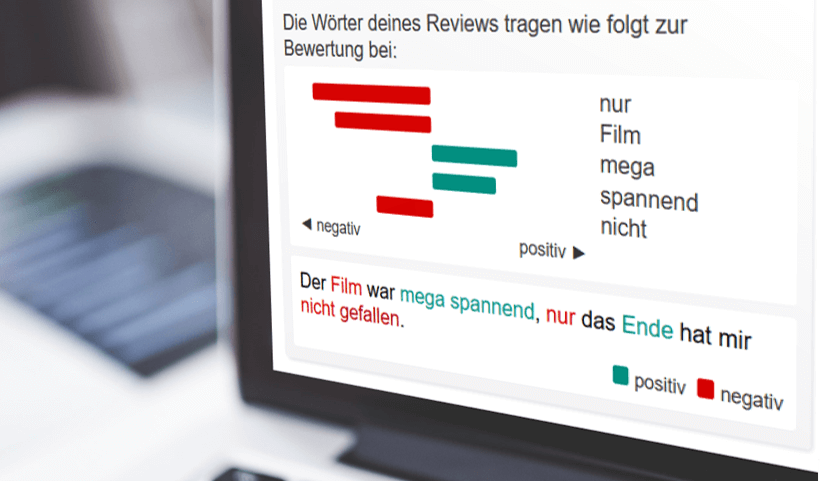

Der „XAI-Demonstrator“ ist eine Online-Anwendung, die das Ziel hat, der interessierten Öffentlichkeit das Forschungsfeld Erklärbare KI näherzubringen. Gleichzeitig ist er unsere Plattform, um die Praxistauglichkeit von XAI-Methoden zu erproben und zu verbessern.

Nutzer*innen können in zwei Anwendungsfällen selbst die Hilfe eines KI-Systems in Anspruch nehmen. Nachdem die KI ihre Entscheidungen generiert hat, werden diese live durch eine Erklärbare KI transparent gemacht. So kann jeder Erklärbare KI spielerisch und anwendungsbezogen kennenlernen. Ergänzt wird der XAI-Demonstrator um eine Lehreinheit, die neben der Vermittlung von methodischen und konzeptionellen Grundlagen die entsprechenden Anwendungsmöglichkeiten mithilfe des XAI-Demonstrators direkt erfahrbar macht.

Im Hintergrund ist der XAI-Demonstrator eine moderne Web-App, deren Backend als cloud-basierte Microservice-Architektur ausgelegt ist. Mit einem zeitgemäßen, robusten Tech Stack bringt er XAI-Algorithmen aus dem Forschungslabor auf einer produktionsreifen Infrastruktur zur Anwendung.

Die initiale Entwicklung des XAI-Demonstrators wurde von der Peter-Horvath-Stiftung unterstützt.

Wie entwickelt man XAI-Methoden so, dass sie die Handlungsfähigkeit ihrer Nutzer*innen verbessern? Unser User-Centric XAI Process gibt Entwickler*innen und Forscher*innen eine strukturierte Vorgehensweise an die Hand, wie sie neue XAI-Methoden nutzerzentriert entwickeln bzw. XAI-Methoden entlang von Nutzerbedürfnissen kalibrieren können.

Die Entwicklung von XAI-Systemen mithilfe des Prozesses stellt sicher, dass die resultierenden Erklärungen tatsächlich den Umgang von Nutzer*innen mit der konkreten KI-Anwendung verbessern. Beispielsweise sorgen die Erklärungen für ein besseres Verständnis der Nutzer*innen für die Funktionsweise der KI, steigern das Vertrauen in die KI, erleichtern das Monitoring der KI und sorgen dafür, dass Mensch und KI zusammen besser entscheiden als Mensch oder KI alleine. Der Prozess kann auf beliebige XAI-Methoden und Anwendungsfelder von KI angewandt werden.

Der Prozess hat seinen Ursprung in der Forschung am Institut für Business Analytics der Universität Ulm und stellt unsere Erfahrung in der Entwicklung von nutzerzentrierten XAI-Systemen auf eine wissenschaftlich fundierte Basis.

Möchten Sie mehr darüber erfahren?

Kann Pepper auch in Ihrer Organisation zu einem besseren Kundenerlebnis beitragen?

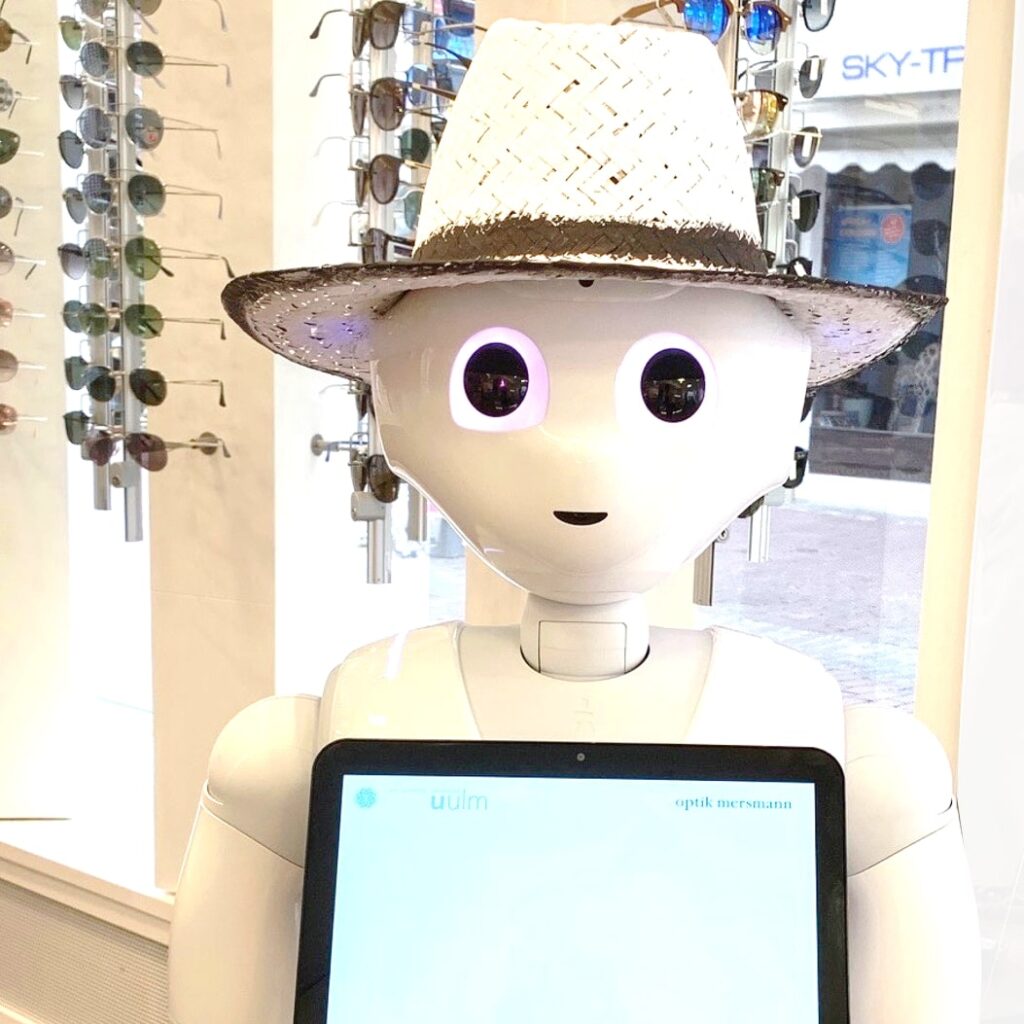

„Pepper“ ist ein humanoider Roboter – also ein Roboter, der dem Menschen nachempfunden ist. Er erkennt Emotionen anhand der Mimik und des Tonfalls seines menschlichen Gegenübers und reagiert durch Anpassung seiner eigenen Gestik, Mimik und Sprache. Pepper wurde schon auf Kreuzfahrtschiffen, in Zügen und Supermärkten eingesetzt, um durch seine kommunikative Art die Zufriedenheit von Kunden zu steigern.

Wir setzen am Institut für Business Analytics moderne KI-Methoden ein, um Pepper auch für anspruchsvollere Aufgaben im Kundenservice fit zu machen. Pepper besitzt so die Fähigkeit, eine große Menge an Daten aus der physischen Welt über verschiedene Sensoren aufzunehmen, diese mit Wissen aus (Online-)Datenbanken zu verknüpfen und sie schließlich schneller, genauer und objektiver zu verarbeiten als Menschen. Beispielsweise haben wir unseren hauseigenen Pepper mit einem Empfehlungssystem ausgestattet, um in einem Optikergeschäft Kund*innen bei der Auswahl von modisch passenden Brillen individuell zu beraten, was diese als sehr gewinnbringend wahrgenommen haben.

Im nächsten Schritt wollen wir Methoden der Erklärbaren KI einsetzen, damit Pepper nicht nur seine datenbasierte und objektive Perspektive einbringt, sondern sich und seine Empfehlungen auch erklärt. Die dafür nötige Software und Algorithmik entwickeln unsere Expert*innen maßgeschneidert für den jeweiligen Anwendungsfall.

© 2022 Erklärbare KI | Institut für Business Analytics der Universität Ulm